深度學習及其在凝態物理上的應用 – 下篇: 深度學習與凝態物理

- 物理專文

- 撰文者:皮旭庭

- 發文日期:2019-01-07

- 點閱次數:1057

前面我們花了不少篇幅講述了深度學習的原理以及歷史,然而我們卻沒有提及深度學習究竟在物理上有何應用,所以這篇裡面,我們就來好好聊聊深度學習究竟在凝態物理上有何應用。

在開始討論應用之前,我們必須要了解到一個事實:深度學習本身是數據科學的一個分支。

“ 因此深度學習本身存在兩個面向,一個是數據,一個是科學。”

特別提出這點是什麼意思呢?我想強調的是,既然深度學習在本身是數據科學的一部分,它在物理上的應用自然也該從數據以及科學兩個面向來做討論。

從數據上的角度來看,任何有數據的領域,深度學習都可以作為一個強而有力的工具,例如在實驗上,我們可以使用深度學習找尋出實驗數據的內在規律,分析以往難以用簡單的物理公式分析的問題,又例如在做計算時,我們可以先用理論計算出一部分的數據,然後餵給模型,讓它大批量的替我們發現更多仰賴昂貴的計算資源才能獲得的訊息。這是從數據的面向來看的。

這時候可能有人會問,那如果我從事的領域並不涉及大量的數據,我又該怎麼涉足深度學習的研究呢?這就是屬於科學的面向了。事實上深度學習的理論本身和物理上的熱力學是息息相關的,除了諸多從資訊熵的角度討論深度學習的工作持續的在發表外,最近也有一些工作表明深度學習與物理上的重整化群是存在高度關聯的,這些都是有志於從理論的角度切入深度學習的物理學者可以努力的方向。此外深度學習還涉及大量的理論數值計算技巧,例如對非凸問題的優化,例如在深度學習的優化過程中透過引入噪音來提升泛化性等等,這些理論在發展的過程中,都與數學還有物理產生過多次的碰撞,激盪出許多火花。過去這幾年對於深度學習得基礎研究越來越多,所以也有許多人從拓樸,幾何的方向切入深度學習,相關的工作可謂一言難盡。

在接下來的討論裡,我將簡單的摘要一些最近與凝態物理相關的工作,讓大家有個粗淺的認識。(這些工作中,不見得每個工作都使用了深度學習,有些可能只使用的是傳統的淺層學習,不過理論上淺層學習能做得好的問題,深度學習通常可以做得更好,所以下面的介紹中我就不做特別區分了。)

數據面向:預測新的材料

這是深度學習一個很具有潛力的方向,也是較具商業價值的方向,簡單的說就是透過已知的材料數據,利用各種機器學習的方法找出材料之間的內在規律,用以預測新的材料,這方面的工作非常多,難以一一列舉,值得一提的例子是矽谷新創公司Citrine。這間公司的CEO Greg Mulholland本身就是電機與材料背景出身的,畢業後工作了幾年開了這間新創公司,主要的業務集中在建立材料相關數據庫,並提供材料開發方面的諮詢服務,他們曾有多篇文章發表,例如利用機器學習來尋找高溫超導材料的可能性[1],以及利用機器學習找出新的Full-Heusler Compounds [2]等等。

其他最近發表的文章,例如工作例如Lu等人[3]也使用了DFT搭配了機器學習來尋找perovskite材料。此外,幾個月前,知名的數據科學賞金網站Kaggle也曾舉辦過材料預測大賽,選賞5000英鎊,要預測復合材料(AlxGayInz)2NO3N的能隙與結合能,藉此來找出適當的x,y,z組合,使得材料可以是透明的半導體,這個競賽也吸引了全球超將近900支隊伍參賽,最後奪冠的團隊以誤差僅0.05eV取得獎金![4]

圖一:Kaggle於今年初舉辦的透明材料性質預測大賽

數據面向:對物理的相做分類

相變是物理上常見的一類問題,但是要能夠簡單的分別各種不同的相已經找出相應的序參量並不容易。這也是機器學習可以發揮功用的地方,例如加拿大Perimeter Institute的研究團隊發現,使用卷積神經網路可以有效地對各種不同形式的Hamiltonian的相變做出判斷,即使是一些存在非平庸的序參量的系統也能夠表現得很好,類似的主題已經多篇發表在Nature Physics上[5,6]。

除此之外,也有不同的研究嚐試使用了深度學習中的自編碼神經網路對2D Ising以及XY model作非監督學習,提取出抽象特徵對不同的相進行分類,結果也表明使用非監督學習提取出的抽象特徵可以對應到已知的序參量[7]。

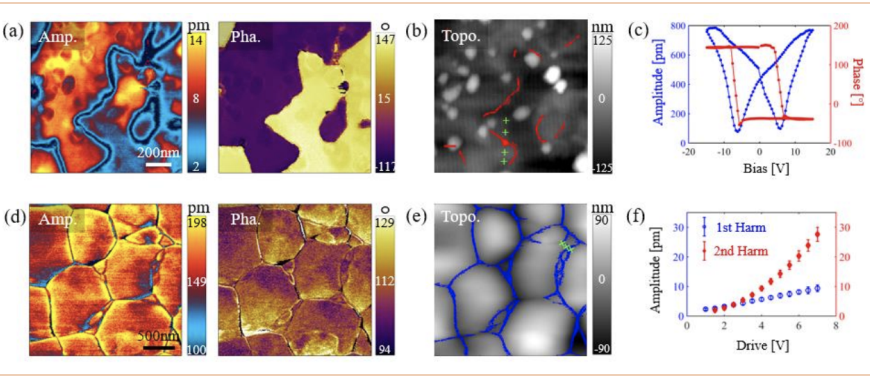

另外在今年的三月份Oak Ridge的研究團隊也提出了使用機器學習基於實驗數據來判斷鐵電材料相變的方法[8]這些研究都表明,使用深度學習對物理的相變問題進行分析是可行的。

數據面向:加速複雜的計算

在凝態物理中,許多問題所要求的計算量是極大的,因此也有研究著重如何使用深度學習來加速計算。這類問題的想法是,如果我們能教會深度學習去計算一個很複雜的方程,那麼當我們以後要在計算類似問題的時候,我們就可以選擇讓模型給我們一個還不錯的近似解,而非直接動用到數值解,這就可以為我們剩下不少的計算資源。

例如X. Liang等人就曾提出了使用了深度學習中的殘差網路(ResNet)的技巧,讓模型學會解在Bose-Enistein Condensation中常遇到的Gross-Pitaevskii equation,他們的結果發現深度學習能夠非常精準的預測出相應的波函數,而且誤差達到10-4這個數量級,結果可謂出乎意料的好[9]。

數據面向:指導新穎材料設計方向

前面我們提過使用深度學習來預測新材料的存在,然而在分子物理領域,由於可以透過各種技巧合成新的分子,他們更在乎的是透過深度學習給予他們一個合成新材料的指導,例如哪些分子值得合成,又該用什麼方法合成。哈佛大學的Sanchez-Lengeling最近也在Science發表了一篇文章,系統的回顧了一系列這樣的工作。特別要強調的是,在該文章中他們特別討論了生成模型的應用[10]。

生成模型是深度學習中的一個子領域,這類模型主要的功用並不是為了預測什麼東西,而是要讓機器學會創造某些數據,例如翻譯就是一個例子,當我們輸入中文,我們希望模型能夠生成相應的英文,又例如當我們輸入一些描述,模型就能夠生成一幅相應的畫,這些都是生成模型的粒子,而這樣的能力恰恰提供了在設計新材料時的指導方向。

另一篇類似的回顧工作則發表在今年八月的Nature 上[11],對這類問題感興趣的讀者,千萬不要錯過這些精采的文章了。

數據面向:輔助實驗儀器的開發

深度學習一個強悍的領域就是圖形識別,基於這個優勢,也有研究團隊開發了AI-AFM [12],簡單的說在AFM顯微鏡上配置了基於深度學習的影像識別系統,能夠在擷取數據的同時,自動的對影像進行識別,除此之外,還可以找出critical domain walls以及grain boundaries整個過程中完全不需要人為的干預。透過這樣的系統能夠大幅加速實驗的速度。

要特別一提的是,AI領域常常存在所謂的用數據養數據的觀念。簡單的說,好的AI模型是仰賴大量的數據訓練出來的,一般來說數據的量越大,模型的表現通常越好。因此當我們有了一個AI可以加速處理大量的數據時,這也意味著我有能力在同樣的時間之內製造出更多的數據,再把這些數據反饋給AI,AI的表現也就會更好,最終形成一個正向的循環,形成所謂的數據壁壘,讓競爭者無法超越,最終形成數量極的差異。

以這個AI-AFM的例子來說,當我們有了一個AFM顯微鏡可以自動識別圖形,分析數據結果,而不需要任何人為操作時,我們就可以讓儀器日以繼夜不停地跑,擷取更多的數據,我們只需要之後再人工的把數據做校正,拿來重新訓練AI,AI的表現就會再往上提上,做得更快,更好,產生了更多的數據,如此反覆,最終那些握有數據的團隊會與那些沒有數據的團隊逐漸拉開形成數量級差距,而且短時間內無法追上。這就是所謂的數據壁壘,這也是為什麼矽谷巨頭們對於數據如此重視,因為唯有數據才能訓練出好的AI,而有了AI則會製造出更多的數據。

圖二:透過AI-AFM來進行即時影像分析

科學面向:深度學習與熱力學

深度學習中的許多問題是與熱力學息息相關的,例如早期的受限波茲曼機就用到了許多熱力學的觀念,其他如深度學習中常在使用的softmax函數也跟熱力學中的配分函數有密切的關係。最近也有一些研究表明神經網路的運作原理其實和物理中的變分重整化群存在數學上的等價關係[13,14],這些都提供了從不同的角度來了解深度學習的運作原理。

另外還有許多從資訊熵的角度來理解深度學習的工作,例如以色列科學家Tishby發表的從交互熵來理解深度學習的工作就曾引起不小重視[15],類似的工作還有一些工作則是從最大熵的角度來理解深度學習[16]。

可以說深度學習和熱力學有千絲萬縷的關係,剩下的就留待讀者自行挖掘了。

科學面向:優化是個大問題

深度學習本質上是一個在非凸問題(non-convex),因此如何在損失函數中找到具有泛化能力的解一直都是一個很重要的問題。在深度學習中處理這問題的手段很多,三言兩語也說不完,大致上來說可以分成幾類:從優化方法下手,從引入隨機性下手,以及從引入正規化下手。

所謂從優化方法下手指的是深度學習在計算梯度誤差時,如何找出更好的方法來更穩定的走向優化解,其中一個非常有效的方法是由Hinton提出的RMSprop[17]方法,該方法引入了物理中的動量的觀念來修正優化的路徑。

另外引入隨機性則是透過在訓練過程中引入一些隨機的噪音避免模型走向過擬合,常見的方法有mini batch gradient descent,dropout等等,由於物理問題中也常遇到許多與隨機性,與噪音有關的問題,因此如果能夠將物理上引入隨機性的技巧引入深度學習中,相信也是滿有趣的工作。

而引入正規化的意思是在深度學習的損失函數上加上一些限制條件,避免模型走向過擬合的解,此前Google的研究亦表明引入基於熵的正規化可有效提升泛化能力[18],這些研究都是和物理息息相關的部分。

科學面向:物理事實該怎麼學習

前面我們提到了許多深度學習應用在物理上的工作,然而單純的把深度學習用在物理問題上並不意味著我們總是能得到好的結果,因為我們的數據也許並不真的具有了完備的物理知識。舉個例子,例如我們計算了大量的關於材料的基本性質,例如能隙,例如結構等等的參數,然後我們想訓練一個模型產生出相應的tight-binding Hamiltonian參數能夠擬合這些性質,這確實是有可能辦到的,而且可能也不難。那麼我們可以問一個問題:請問拿這個tight-binding Hamiltonian去計算其他的物理性質,例如光學性質,熱力學性質等等,請問結果可信嗎?答案是未必!

理由很簡單,因為我們的輸入資訊不完備!

以前面的例子來說,我們確實有可能建構一組參數,使得tight-binding Hamiltonian能夠得出得出相似的性質,但是這組參數很可能是不唯一的。事實上在整個參數空間中,可能存在多組參數都能夠得出類似的性質,但是我們並無法保證模型給我們的是符合物理定律的那一組。類似的問題如果不能被妥善的處理,將可能導致很荒謬的錯誤,因此如何把物理的先驗知識引入模型中,一直是個滿有趣的問題。A. Karpatne等人亦曾發表過類似的工作[19],有興趣的人可以看一看。

科學面向:拓樸與幾何之謎

深度學習中還有一個新興的領域,稱作流形學派,這個學派認為,深度學習一層一層的特徵提取,其實本質上就是一種對數據分布的流形(manifold)的一種變化,直到把數據逐漸變化到接近線性可分,我們就達成了數據分類的目的了。這是一個合理的想像,對於一些簡單的測試也確實能看到類似的結果。

這個學派進一步假設,我們觀察到的數據其實都是從一個低維度的流形映射到高維空間上的,而這樣的映射會產生維度上的冗餘。例如我們的數據分佈在一個二維的圓上,在這個情況下,其實我只需要使用一個座標就能夠對數據的位置做出描述了,然而如果我們使用了二維的直角座標來描述就會產生了冗餘。其結果是,這個數據分佈中,兩個相鄰的點最好的做法應該是用一條彎的繩子貼著這個圓繞來衡量遠近的,但是在二維直角坐標中,我們卻糊裡糊塗用了歐式距離來衡量距離,自然模型表現就不好了。

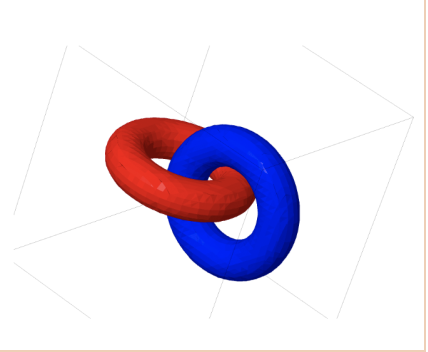

這樣的觀點可以延伸到一個類的數據所分佈的流形被另一個類的流形所包圍,那麼該怎麼樣有效的將它分離的拓樸學問題。關於這方面的工作,Google AI的研究員Christopher Olah曾經寫過一篇非常好的介紹,有興趣的人可以好好讀一讀他的文章[20]。

圖三:兩個數據集所分布的流形彼此鏈結的例子(linked tori)

總結

一連三篇長文,洋洋灑灑的從深度學習的歷史開始,介紹到了卷積神經網路以及循環神經網路,最後簡單的介紹了一些深度學習在在凝態物理上的應用。看似內容很多,其實僅僅是滄海之一粟,這問題真要詳談恐怕幾本書都不夠,但作為一篇拋磚引玉的文章,我想已是足夠了。

最後要強調的是,礙於個人才疏學淺,文章中的敘述恐有不盡完備之處,有賴各位分享指正,以求精進。

延伸閱讀:

深度學習及其在凝態物理上的應用 – 中篇: CNN與RNN

深度學習及其在凝態物理上的應用 – 上篇:什麼是深度學習

想要訂購並贊助物理雙月刊的朋友請走這裡:

一年份訂購:https://cashier.ecpay.com.tw/store/3rg26

電子雜誌租購:https://ebook.hyread.com.tw/bookDetail.jsp?id=163393

紙本雜誌單本訂購:https://www.books.com.tw/products/R030078974

參考文章:

[1] Bryce Meredig et. al., DOI: 10.1039/C8ME00012C (2018)

[2] Anton O. Oliynyk et. al., Chem. Mater., 2016, 28 (20), 7324

[3] S. Lu et.al., Nat. Comm. 9 3405 (2918)

[4] https://www.kaggle.com/c/nomad2018-predict-transparent-conductors

[5] Juan Carrasquilla & Roger G. Melko, Nature Physics 13, 431 (2017)

[6] Evert P. L. van Nieuwenburg, etl. al, Nature Physics 13, 435 (2017)

[7] Sebastian J. Wetzel, Phys. Rev. E 96, 022140 (2017)

[8] L. Li et. al., Science Advances 4 3 eaap8672 (2018)

[9] X. Liang et. al, arXiv 1712.10093 (2017)

[10] Benjamin Sanchez-Lengeling & Alán Aspuru-Guzik, Science 361 360 (2018)

[11] K. Butler et. al., Nature 559 547 (2018)

[12] B. Huang. et. al., arXiv 1807.09985 (2018)

[13] Pankaj Mehta & David J. Schwab, arXiv 1410.3831 (2014)

[14] Shuo-Hui Li & Lei Wang, arXiv:1802.02840 (2018)

[15] avid Shwartz-Ziv & Naftali Tishby, arXiv:1703.00810 (2017)

[16] G. Zheng, arXiv:1711.07758 (2017)

[17] 此工作雖廣泛地使用在深度學習領域,Hinton本人未曾正式發表過該工作,最早提出於他的課程講義中 https://www.cs.toronto.edu/~tijmen/csc321/slides/lecture_slides_lec6.pdf

[18] Gabriel Pereyra et. al., arXiv:1701.06548 (2017)

[19] Anuj Karpatne etl. al., arXiv 1710.11431 (2017)

[20] http://colah.github.io/posts/2014-03-NN-Manifolds-Topology/